Штучний інтелект і дезінформація: можливості та ризики в умовах війни

Надання компанією OpenAI безкоштовного доступу до свого чат-бота ChatGPT, публікація в соцмережах великої кількості зображень, створених з допомогою Midjorney та інших нейромереж, зробили цей інструмент як ніколи близьким для пересічних інтернет-користувачів. Це актуалізувало дискусії про ризики та можливості, які створює штучний інтелект під час інформаційних воєн.

Як штучний інтелект допомагає в роботі з інформацією

ШІ має великий потенціал для створення та опрацювання контенту. Центр стратегічних комунікацій та інформаційної безпеки використовує можливості ШІ для моніторингу медіапростору та аналізу масиву онлайн-публікацій. Йдеться про автоматизовані засоби, зокрема, платформи SemanticForce і Attack Index.

Серед інструментів семантичного аналізу, які застосовує SemanticForce, є ШІ. Він допомагає виявляти інформаційні тренди, відстежувати зміни реагування користувачів соціальних мереж на інформаційні приводи, виявляти мову ненависті тощо. Ще одним вектором застосування нейронних мереж є детальний аналіз зображень, який дозволяє швидко виявляти неприйнятний чи шкідливий контент.

Attack Index використовує машинне навчання (оцінка тональності повідомлень, рейтингування джерел, прогнозування розвитку інформаційних динамік), кластерний аналіз (автоматизоване групування текстових повідомлень, виявлення сюжетів, формування сюжетних ланцюжків), комп’ютерну лінгвістику (для виявлення сталих словосполучень та наративів), формування, кластеризацію та візуалізацію семантичних мереж (для визначення зв’язків та вузлів, розбудови когнітивних мап) та кореляційний і вейвлет аналіз (для виявлення інформаційних операцій).

Наявні інструменти дозволяють за допомогою ШІ розрізняти органічне та скоординоване розповсюдження контенту, виявляти автоматизовані системи розповсюдження спаму, оцінювати вплив на аудиторію різних облікових записів користувачів соцмереж, відрізняти ботів від реальних користувачів тощо.

Вони можуть використовуватись як для виявлення дезінформації, аналізу дезінформаційних кампаній, так і для розробки заходів з реагування та протидії.

Потенціал ШІ для створення і поширення дезінформації

Нейромережі ледь не щодня демонструють покращення своїх навичок зі створення графічного, текстового та аудіовізуального контенту. Його якість зростатиме з урахуванням можливостей машинного навчання. Сьогодні популярні нейромережі використовуються інтернет-користувачами скоріше як іграшка, ніж інструмент для створення фейків.

Втім вже зараз є приклади того, як згенеровані нейромережами зображення не просто ставали вірусними, а й сприймалися користувачами як реальні. Зокрема зображення «хлопчика, який вижив під час ракетного удару в Дніпрі», або «путіна, що на колінах вітав Сі Цзіньпіна».

Ці приклади наочно демонструють, що створені за допомогою нейромереж зображення вже конкурують із реальними за рівнем яскравості та емоційності, і це обов’язково буде використано з метою дезінформації.

Дослідження аналітичного центру NewsGuard, проведене в січні 2023 року, виявило, що популярний чат-бот ChatGPT здатен генерувати тексти, що розвивають наявні конспірологічні теорії та включають в їх контекст реальні події. Цей інструмент має потенціал для автоматизованого розповсюдження (з допомогою ботоферм) великої кількості повідомлень, тему і тональність яких визначатиме людина, а безпосередній текст ‒ генеруватиме ШІ. Уже сьогодні з допомогою цього бота можна створювати дезінформаційні повідомлення, у тому числі засновані на наративах кремлівської пропаганди, формулюючи відповідні запити. Протидія поширенню штучно згенерованого неправдивого контенту ‒ це виклик, готуватися відповідати на який треба було вже буквально вчора.

Використання ШІ на війні: чого чекати від росіян

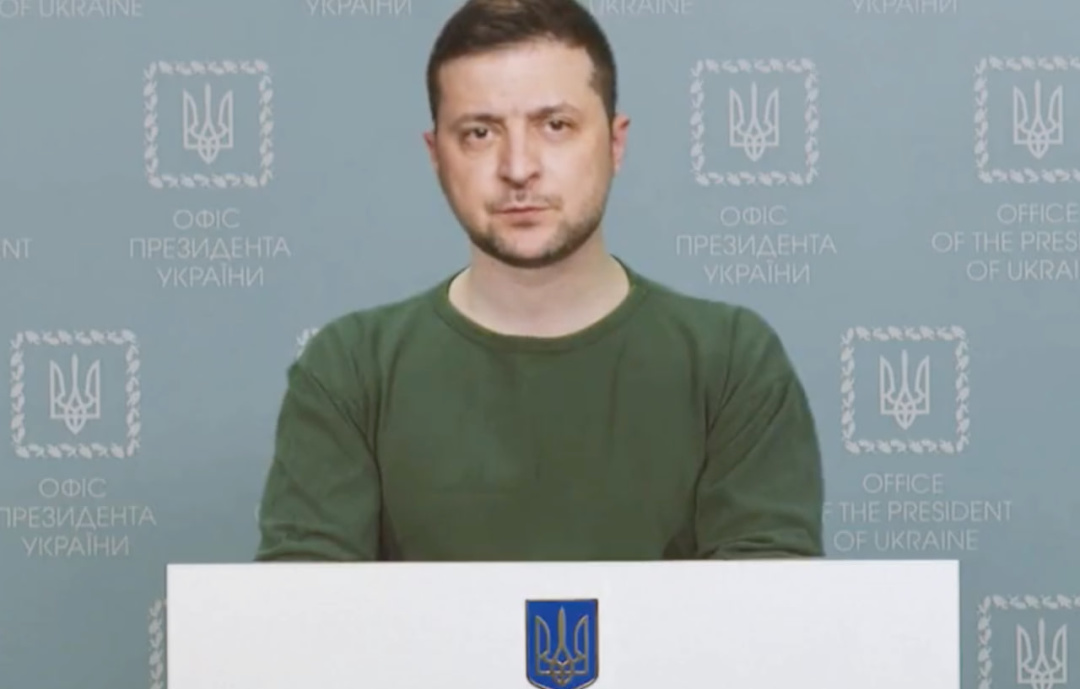

Спецслужби РФ мають великий досвід застосування фото- та відеомонтажу для створення фейків та проведення психологічних операцій та активно освоюють ШІ. На ШІ базується технологія діпфейк. Її було використано, зокрема, для створення фейкового відеозвернення президента Зеленського про капітуляцію, вкинуте в інфопростір у березні 2022 року.

З огляду на низьку якість цього «продукту», оперативну реакцію державних комунікацій, президента, який особисто спростував фейк, і журналістів, це «не взлетіло». Відео не досягло своєї мети ні в Україні, ні за кордоном. Але зупинятися росіяни, вочевидь, не збираються.

Сьогодні для розповсюдження дезінформації Кремль використовує величезну кількість інструментів: телебачення, радіо, інтернет-сайти, блогерів-пропагандистів, які генерують і просувають контент у Telegram, Youtube, соціальних мережах.

ШІ має потенціал для використання, насамперед, для створення фото-, аудіо- і відеофейків, а також для роботи ботоферм. ШІ може замінити значну частину персоналу на російських «фабриках тролів», інтернет-бійців, які провокують конфлікти в соцмережах та створюють ілюзію масової підтримки кремлівських наративів користувачами.

Замість «тролів», що пишуть коментарі за методичками, це може робити ШІ з використанням ключових слів та запропонованої йому лексики. Визначальний вплив на лояльну аудиторію мають згадані вище інфлюенсери (політики, пропагандисти, блогери, конспірологи тощо), а не безіменні боти та інтернет-тролі. Однак з допомогою ШІ вагу останніх можна збільшити за рахунок кількісного зростання та «тонкого налаштування» під різні цільові аудиторії.

Український уряд ще у 2020 році затвердив «Концепцію розвитку штучного інтелекту». Цей рамковий документ визначає штучний інтелект як комп’ютерну програму, відповідно правове регулювання використання ШІ ‒ таке саме, як і в інших програмних продуктів. Отже, говорити про якесь нормативно-правове регулювання ШІ поки що зарано.

Розвиток ШІ випереджає створення запобіжників від його недоброчесного і зловмисного використання та формулювання політик щодо його регулювання.

Тому співпраця українських урядових структур із Big Tech компаніями у напрямку протидії розповсюдженню дезінформації та виявлення й ліквідації ботоферм має лише поглиблюватись. У цьому зацікавлені як наша держава, так і світові технологічні гіганти.

Центр стратегічних комунікацій та інформаційної безпеки